黃仁勳在 2025 GTC 上宣布英偉達將投資諾基亞 10 億美元,共同開發 AI-RAN 技術,瞄準價值 2000 億美元的 RAN 市場。

(前情提要:輝達砸10億美元入資諾基亞成最大股東!Nokia大漲21%,黃仁勳背後在打什麼主意? )

(背景補充:Nokia 將推出 Web3 手機?申請數位資產加密專利,看好區塊鏈發展 )

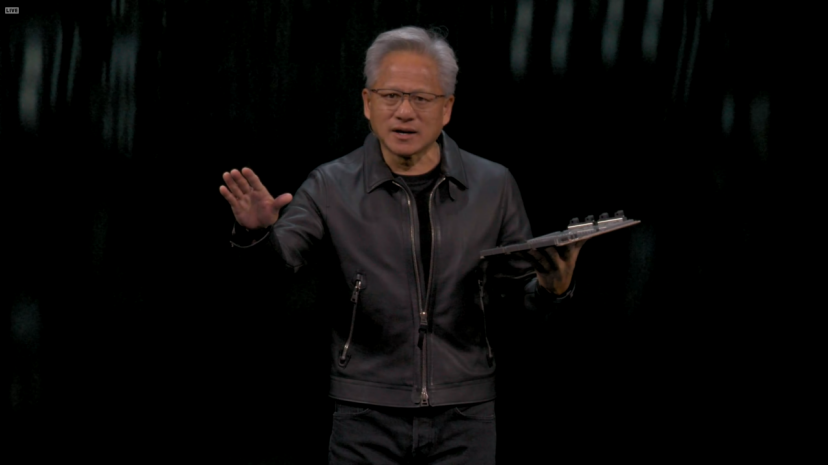

在 2025 年的 GTC 上,黃仁勳放出了一個猛料,英偉達將投資諾基亞 10 億美元。對,就是那個 20 年前火遍大江南北的塞班手機公司諾基亞。

黃仁勳在演講中說,電信網路正處於從傳統架構向 AI 原生系統的重大轉變中,而英偉達的投資將加速這一進程。於是英偉達就以投資的方式,和諾基亞共同創建一個面向 6G 網路的 AI 平台,把 AI 賦能到傳統的 RAN 網路中。

具體的投資形式是英偉達以每股 6.01 美元的價格認購諾基亞約 1.66 億股新股,這將使英偉達持有諾基亞約 2.9% 的股權。

就在宣布合作的一剎那,諾基亞股價上漲了 21%,是 2013 年以來的最大漲幅。

什麼是 AI-RAN?

RAN 就是無線接入網,而 AI-RAN 將 AI 計算能力直接嵌入到無線基站中的新型網路架構。傳統的 RAN 系統主要負責在基站和移動設備之間傳輸資料,而 AI-RAN 則在此基礎上增加了邊緣計算和智慧處理功能。

讓基站能夠應用 AI 演算法來優化頻譜利用率和能源效率,改善整體網路效能,同時還能利用閒置的 RAN 資產託管邊緣 AI 服務,為營運商創造新的收入來源。

營運商可以在基站現場直接運行 AI 應用,而不必將所有資料傳回中心資料中心處理,大大減少了網路的負擔。

黃仁勳舉了個例子,幾乎 50% 的 ChatGPT 使用者都是透過移動設備進行存取,不僅如此,ChatGPT 的月度移動下載量超過了 4000 萬,在 AI 應用爆炸式成長的年代,傳統的 RAN 系統沒辦法應對生成式 AI 以及智慧體主導的移動網路。

而 AI-RAN 透過在邊緣提供的分散式 AI 推理能力,讓接下來的 AI 應用,比如智慧體、聊天機器人回應更快。同時,AI-RAN,也是為 6G 時代的整合感測和通訊應用做好準備。

黃仁勳引用了分析師公司 Omdia 的預測,該公司預計 RAN 市場到 2030 年將累計超過 2000 億美元,其中 AI-RAN 部分將成為成長最快的細分領域。

諾基亞總裁兼執行長賈斯汀·霍塔德在聯合聲明中表示,這一夥伴關係將把 AI 資料中心放入每個人的口袋中,實現從 5G 到 6G 的根本性重設計。

他特別提到,諾基亞正在和英偉達、戴爾、T-Mobile 這三家不同類型的企業合作。T-Mobile 作為首批合作夥伴,將從 2026 年開始進行 AI-RAN 技術的實地測試,重點驗證效能和效率提升。賈斯汀說這項測試將為 6G 創新提供寶貴資料,幫助營運商構建適應 AI 需求的智慧網路。

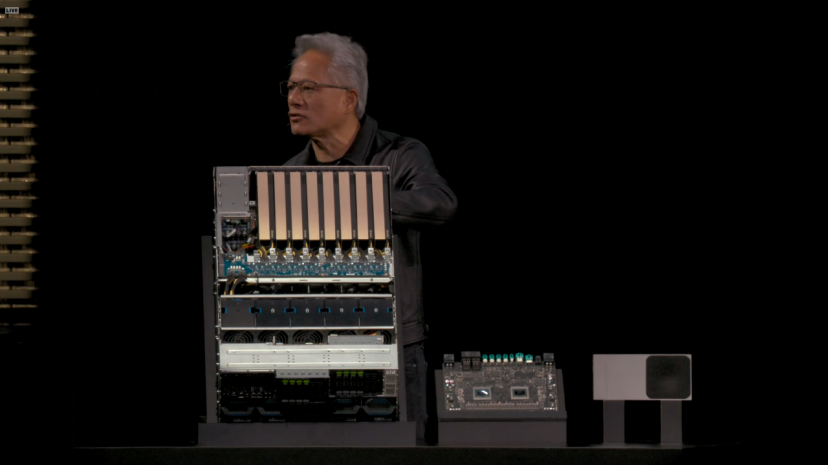

基於 AI-RAN,英偉達發布的新產品叫做 Aerial RAN Computer Pro(ARC-Pro),這是一個為 6G 準備的加速計算平台。它的核心硬體配置同時包含了英偉達的兩種 GPU:Grace CPU 和 Blackwell GPU。

這個平台透過 NVIDIA CUDA 運行,RAN 軟體可以直接嵌入到 CUDA 技術棧中。因此,它不僅能處理傳統的無線接入網功能,還能同時運行主流的 AI 應用。這也是英偉達實現 AI-RAN 中 AI 兩個字母的核心方法。

鑑於 CUDA 悠久的歷史,這個平台的最大優勢其實是可程式性。不止是這樣,黃仁勳還宣布將 Aerial 軟體框架開源,預計從 2025 年 12 月開始在 GitHub 上以 Apache 2.0 許可證發布。

ARC-Pro 與其前代產品 ARC 的主要區別在於部署位置和應用場景。前代 ARC 主要用於集中式雲 RAN 實現,而 ARC-Pro 則可以直接部署在基站現場,這使得邊緣計算能力得以真正落地。

英偉達電信業務負責人羅尼·瓦希塔說,過去 RAN 和 AI 需要兩套不同的硬體才能實現,但是 ARC-Pro 可以根據網路需求動態分配計算資源,既可以優先處理無線接入功能,也可以在閒置時段運行 AI 推理任務。

ARC-Pro 還整合了英偉達 AI Aerial 平台,這是一個完整的軟體棧,包括 CUDA 加速的 RAN 軟體、Aerial Omniverse 數位孿生工具和新的 Aerial Framework。Aerial Framework 可以將 Python 程式碼轉換為高效能的 CUDA 程式碼,在 ARC-Pro 平台上運行。此外,平台還支援 AI 驅動的神經網路模型,用於高級通道估計。

黃仁勳說,電信是經濟和安全的數位神經系統。與諾基亞和電信生態系統的合作,將點燃這一革命,幫助營運商構建智慧、適應性的網路,定義下一代全球連接。

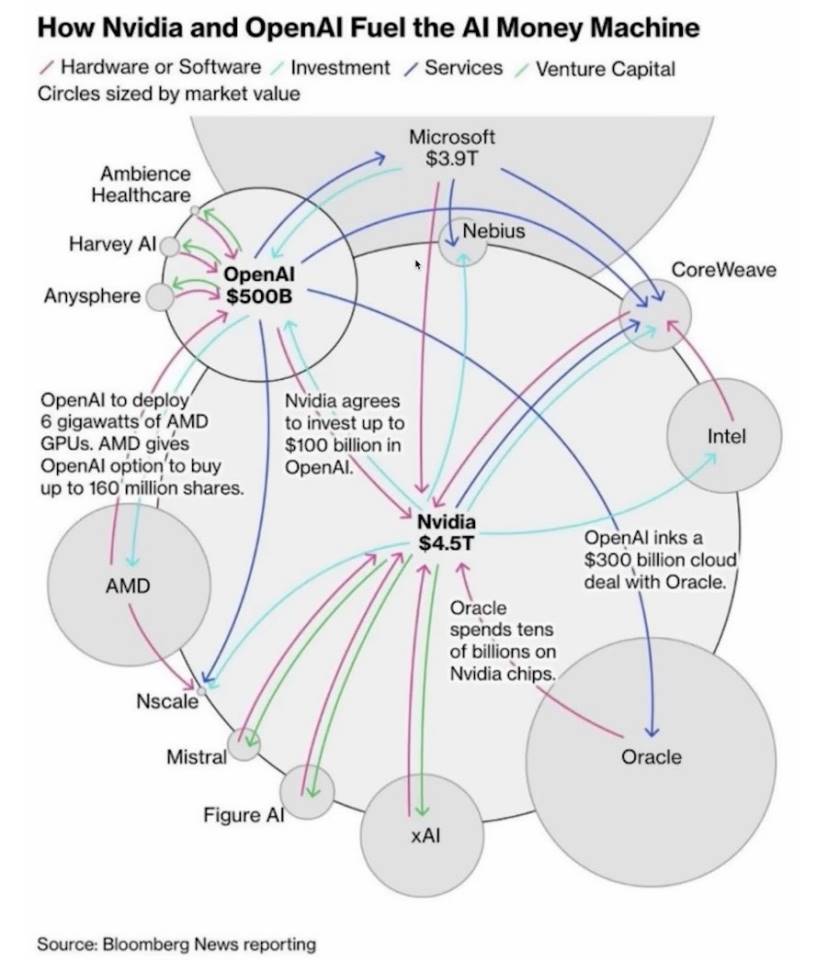

放眼 2025 年,英偉達真的投了不少錢。

9 月 22 日,英偉達和 OpenAI 達成合作,英偉達計劃逐步向 OpenAI 投資 1000 億美元,這將加速其基礎設施建設。

黃仁勳說,其實 OpenAI 很久前就尋求英偉達的投資,但當時公司資金有限。他幽默地說,當時太窮,其實應該把所有錢都給他們。

黃仁勳認為,AI 推理成長不是 100 倍或 1000 倍,而是 10 億倍。而且這一合作不僅限於硬體,還包括軟體優化,確保 OpenAI 能高效利用英偉達的系統。

這可能是因為他在了解到 OpenAI 和 AMD 合作後,擔心 OpenAI 放棄 CUDA。一旦全球最大的 AI 基礎大模型不使用 CUDA,那麼其他大模型廠商效仿 OpenAI,也是情理之中的事情。

黃仁勳在 BG2 播客節目中預測,OpenAI 很可能成為下一個兆美元市值的公司,其成長速度將創下行業紀錄。他反駁了 AI 泡沫論,指出全球每年在 AI 基礎設施上的資本支出將達到 5 兆美元。

也正是因為這筆投資,OpenAI 在 10 月 29 日宣布完成公司資本重組。公司被拆分成了兩部分,一部分是非營利基金會,另一部分就是營利性公司。

非營利性質的基金會將在法律上控制營利性的部分,且必須兼顧公共利益。但是依然可以放開手腳去融資或收購公司。基金會將擁有這家營利性公司 26% 的股份,並持有一份認股權證。如果公司繼續發展壯大,基金會還能獲得額外股份。

除了 OpenAI,英偉達在 2025 年還投資了馬斯克的 xAI。這家公司當前融資輪次規模提升至 200 億美元。其中約 75 億美元透過股權募集,至多 125 億美元透過特殊目的實體(SPV)的債權募集。

這個特殊目的實體的運作方式是,它將使用募集到的資金購入英偉達的高效能處理器,然後將這些處理器出租給 xAI 使用。

這些處理器將被用於 xAI 的 Colossus 2 項目。Colossus 初代是 xAI 位於田納西州孟菲斯的超級計算資料中心。Colossus 初代項目已經部署了 10 萬個英偉達 H100 GPU,使其成為全球最大的 AI 訓練叢集之一。現在 xAI 正在建設的 Colossus 2,計劃將 GPU 數量擴展到數十萬甚至更多。

9 月 18 日,英偉達還宣布將向英特爾投資 50 億美元,並建立深度戰略合作關係。英偉達將以每股 23.28 美元的價格認購英特爾新發行的普通股,總投資額達 50 億美元,交易完成後,英偉達將持有英特爾約 4% 的股份,成為其重要戰略投資者。

當然,這場 GTC 上黃仁勳還說了很多。

比如英偉達推出了多個開源 AI 模型家族,包括用於數位 AI 的 Nemotron、用於物理 AI 的 Cosmos、用於機器人的 Isaac GR00T 和用於生物醫學 AI 的 Clara。

同時,黃仁勳推出了 DRIVE AGX Hyperion 10 自動駕駛開發平台。這是一個面向 4 級自動駕駛的平台,整合了英偉達計算晶片和完整的感測器套件,包括雷射雷達、攝像頭和雷達。

英偉達還推出了 Halos 認證計劃,這是行業首個用於評估和認證物理 AI 安全性的系統,專門針對自動駕駛車輛和機器人技術。

Halos 認證計劃的核心是 Halos AI 系統,這是行業首個獲得 ANSI 認證委員會認可的實驗室。而 ANSI 是美國國家標準協會,其認證具有很高的權威性和公信力。

這個系統的任務是透過英偉達的物理 AI,來檢測自動駕駛系統是否符合標準。AUMOVIO、Bosch、Nuro 和 Wayve 等公司是 Halos AI 系統檢驗實驗室的首批成員。

為了推動 4 級自動駕駛,英偉達發布了一個從 25 個國家手的多模態自動駕駛資料集,裡面包含了 1700 小時的攝像頭、雷達和雷射雷達資料。

黃仁勳說這個資料集的價值在於其多樣性和規模,它涵蓋了不同的道路條件、交通規則和駕駛文化,為訓練更加通用的自動駕駛系統提供了基礎。

不過黃仁勳的藍圖遠不止於此。

他在 GTC 上宣布了一系列與美國政府實驗室和領先企業的合作,目標是構建美國的 AI 基礎設施。黃仁勳說,我們正處於 AI 工業革命的黎明,這將定義每個行業和國家的未來。

這次合作的重頭戲是與美國能源部的合作。英偉達正在幫助能源部建設兩個超級計算中心,一個在阿貢國家實驗室,另一個在洛斯阿拉莫斯國家實驗室。

阿貢實驗室將獲得一個名為 Solstice 的超級計算機,這個系統配備了 10 萬個英偉達 Blackwell GPU。10 萬個 GPU 是什麼概念?這將是能源部有史以來最大的 AI 超級計算機。另外還有一個叫 Equinox 的系統,配備 1 萬個 Blackwell GPU,預計 2026 年投入使用。這兩個系統加起來能提供 2200 exaflops 的 AI 計算效能。

阿貢實驗室主任保羅·科恩斯說,這些系統將重新定義效能、可擴展性、可靠性和科學潛力。他們要用這些算力來做什麼?從材料科學到氣候建模,從量子計算到核武器模擬,都需要這種級別的計算能力。

除了政府實驗室,英偉達還在維吉尼亞州建了一個 AI 工廠研究中心。這個中心的特別之處在於,它不只是一個資料中心,而是一個實驗場。英偉達要在這裡測試一個叫 Omniverse DSX 的東西,這是一個用於建設千兆瓦級 AI 工廠的藍圖。

一個普通資料中心可能只需要幾十兆瓦的電力,而千兆瓦相當於一個中等規模核電站的發電量。

這個 Omniverse DSX 藍圖的核心思想是讓 AI 工廠變成一個自學習系統。AI 代理會持續監控電力、冷卻和工作負載,自動調整參數來提高效率。比如當電網負荷高的時候,系統可以自動降低功耗,或者切換到儲能電池供電。

這種智慧化管理對於千兆瓦級的設施來說至關重要,因為電費和冷卻成本會是天文數字。

這個願景很宏大,黃仁勳說他需要三年才能實現。AI-RAN 測試要在 2026 年才能開始,基於 DRIVE AGX Hyperion 10 的自動駕駛汽車要到了 2027 年才能上路,能源部的超級計算機也是 2027 年投入使用。

英偉達手握 CUDA 這個殺手鐧,掌握著 AI 計算的事實標準。從訓練到推理,從資料中心到邊緣設備,從自動駕駛到生物醫學,英偉達的 GPU 無處不在。這次 GTC 上宣布的這些投資和合作,進一步鞏固了這個地位。

📍相關報導📍

Telegram 創辦人推出保密 AI 計算網路 Cocoon:主打 GPU 挖礦,深度整合 TON 與 Telegram